En 1996, je rédigeais un article dans une revue aujourd’hui disparue, sur les possibilités offerte pour l’enseignement par l’utilisation des technologies Multimédia et par Internet. Les deux concepts étaient récents à l’époque : le mot multimedia a été forgé vers 1980 et le Web a été proposé en 1989. J’ai trouvé intéressant de me relire, 30 ans plus tard, au point de me décider à republier ce texte… qui n’était pas disponible sur Internet. L’article commence par une Design Fiction (terme dont j’ignorais l’existence à l’époque) très optimiste sur le fait que l’Europe aurait un Bac unifié, dont une des matières serait l’écoscience. Intéressant aussi l’idée que je poussais de séparer l’internet commercial de l’internet éducatif et ma conclusion, que je ne résiste pas à l’idée de citer

Accroître la qualité de l’information disponible, développer des agents intelligents pour y accéder, et reconnaître que sa complexité rend nécessaire l’équivalent d’une constitution pour réguler son fonctionnement : c’est à ce prix qu’Internet pourra devenir un serveur documentaire universel.

Conclusion de Multimédia et Pédagogie, Nicolas Demassieux, 1996

24 avril 2004

Quentin prépare son CCE (Capacité de Citoyen Européen) ; examen européen qui a remplacé le BAC en France en 2001. Il lui reste une semaine de révisions. Au programme : mathématiques, physique, français, anglais, écosciences, sciences humaines et systèmes d’information. Ce matin, il révise son programme de math. A l’aide de son ordinateur, il reprend pas à pas les démonstrations clefs. A tout moment, il peut obtenir une illustration (figure géométrique, animation,…), lui permettant d’appréhender intuitivement les résultats abstraits qu’il démontre. De temps à autre, il visionne ses notes de cours : séquence vidéo de son professeur au tableau expliquant un point délicat, annotations vocales ou manuscrites qu’il a lui-même enregistrées au cours de l’année. Vers 11h, il est interrompu par un appel téléphonique : c’est son correspondant anglais qui prépare lui aussi son CCE et qui veut rafraîchir son accent français. Quentin en profite pour parler avec lui en anglais. La conversation dure une heure. Après le repas, il s’attaque à la physique. Ce qu’il apprécie le plus, c’est le laboratoire. Il se connecte et passe deux heures à réviser son programme d’électricité en réalisant, à l’écran, des montages de plus en plus complexes que lui propose l’ordinateur. C’est maintenant le tour de l’écoscience (biologie, géologie, écologie). Le jour de l’épreuve, Quentin doit présenter à l’examinateur le résultat d’un projet personnel : il a choisi de préparer un exposé multimédia sur la gestion de l’eau. Il fouine quelques instants sur l’EduNet. En 1998, l’ancien Internet a été séparé en un réseau commercial -EcoNet-, un réseau pour l’enseignement -EduNet-, un réseau pour la recherche -RecNet- et un réseau pour les loisirs -FreeNet-. Ces réseaux sont bien entendu interconnectés, mais seul EduNet est totalement gratuit pour Quentin. Il cherche, pour illustrer les résultats encourageants de la récente politique -Zéro Déchet- de l’Europe, une carte montrant l’évolution de la pollution des grands cours d’eau lors des dix dernières années. En quelques instants, grâce aux outils de consultation et à sa bonne connaissance des bases de données, il trouve ce qu’il cherche (finalement, le prof de Systèmes d’Information n’était pas si mauvais que ça!). Il insère la carte dans sa présentation et en profite pour réfléchir à la manière dont il va conduire son exposé. Son prof de sciences humaines leur a souvent dit de faire très attention au contenu de l’exposé. La présentation multimédia n’est là que pour l’aider à mieux transmettre son message. Quentin doit surtout démontrer qu’il connaît son sujet. Il est tard maintenant, et Quentin va se coucher.

Multimédia et pédagogie en 1996

Le mot multimédia, apparu -discrètement- en 1980[1]Le petit Robert, a fait plus récemment irruption dans notre quotidien. Les visions de précurseurs (voir la brève chronologie du multimédia en hors texte) ont été relayées par une frénésie médiatique. Les expérimentations coûteuses et à petite échelle ont fait place au développement de l’usage du multimédia dans de nombreux secteurs économiques. Les investisseurs achètent à grand prix des entreprises créees moins de dix-huit mois auparavant par deux ou trois jeunes passionnés. Microsoft, Intel voient leur situation hégémonique remise en question. Les produits se succèdent à un rythme soutenu : chaque année voit poindre de nouvelles technologies, de nouveaux acteurs, de nouveaux usages.

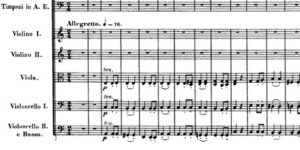

Hors-texte : Une brève chronologie du multimédia

- 1945 Vannevar Bush (Conseiller Scientifique du Président Roosevelt pendant la seconde guerre mondiale) propose MEMEX, une machine conceptuelle pouvant stocker d’énormes quantités d’informations, dans laquelle les utilisateurs ont la capacité de créer des « pistes » d’information, des liens entre textes et illustrations pouvant être enregistrés pour des usages ultérieurs.

- 1965 Ted Nelson crée le mot hypertexte.

- 1967 Andy van Dam et d’autres développent le premier système d’édition hypertexte.

- 1968 Doug Engelbart, du SRI, invente et démontre le premier système avec multi-fenêtrage et la souris lors de la conférence « Fall Joint Computer Conference, San Francisco ». Sa démonstration donna naissance aux interfaces utilisateur actuelles, via le Xerox Parc et Apple.

- 1969 Première transmission sur Internet, entre le SRI et l’Université de Californie à Los Angeles (UCLA). Le réseau INTERNET reliait alors 4 université américaines. Il relie aujourd’hui plusieurs dizaines de million d’ordinateurs.

- 1978 Le premier videodisque hypermedia, démontré au MIT.

- 1981 Ted Nelson imagine « Xanadu », une base de données centralisée hypertexte

- 1987 Apple introduit HyperCard, le premier logiciel grand public permettant de travailler sur des document multimédia

- 1989 Tim Berners-Lee propose le World-Wide Web

- Juin 1994 Conférence internationale sur le multimédia pour la formation (Educational Multimedia and Hypermedia in Vancouver, Canada\)

Stricto sensu, le multimédia n’est pourtant pas chose neuve. Les manuscrits enluminés et les bandes dessinées (textes et dessins), les opéras et le cinéma (images animées et sons), la télévision et les cours magistraux (textes, sons, et dessins) et bien d’autres formes de communication font cohabiter au sein du même support plusieurs formes d’information. Le phénomène nouveau, c’est l’intégration de toutes les formes d’information utilisées par l’homme dans un support unique : le support électronique. Le support électronique a donné au multimédia les clefs de son succès, en mettant à son service les domaines traditionnels de l’audiovisuel, des télécommunications et de l’informatique. L’audiovisuel a apporté la forme : richesse de l’écriture cinématographique, dynamisme du mouvement, esthétique des formes et de la couleur, chaleur des voix,… Les télécommunications ont apporté ubiquité et rapidité : un document multimédia peut être construit rapidement avec des informations en provenance de sources disséminées partout dans le monde ; il peut être diffusé instantanément de la même manière. Enfin, l’informatique a amené l’intelligence : interactivité avec des contenus comme dans l’hypertexte, voire élaboration dynamique de contenus comme dans les mondes virtuels.

On le voit, les trois fées qui se sont penchées sur le berceau du multimédia l’ont, comme dans la légende, doté de nombreuses vertus. A elles-seules, elles expliquent l’importance du phénomène multimédia, mais pas la date de son émergence. Un dernier élément du puzzle, commun au trois fées, est l’aspect économique. Le multimédia, techniquement possible depuis dix ans, n’est économiquement réaliste que depuis quelques années : augmentation des performances des microprocesseurs et des mémoires, apparition de supports peu coûteux pour l’enregistrement (CD-ROM) et la diffusion (Internet), baisse continue des prix des équipements informatique et des télécommunications, mise en place de normes internationales nécessaires au sein de l’ISO et de l’UIT (MPEG,…).

Face à ce déferlement économico-médiatique, il convient de mener une réflexion en profondeur dans deux directions : que sont exactement les technologies du multimédia et quels en sont les usages possibles? Les grandes écoles ont été amenées à se poser ces questions à deux titres. Certaines, comme l’Ecole Nationale Supérieure des Télécommunications, ont pour vocation d’enseigner les technologies qui font le multimédia ; elles se sont demandées comment faire évoluer le contenu de leur formation technique. Toutes étudient comment le multimédia peut être utilisé pour faire évoluer et améliorer la forme et l’efficacité de leur enseignement.

Les technologies du multimédia

On l’a vu, le multimédia recouvre une réalité complexe. D’un point de vue pratique, il est utile de distinguer deux grandes familles de produits : les produits multimédia autonomes, en général présentés sous la forme d’un CD-ROM (off-line) et les produits multimédia accessibles en réseau, en général via Internet (on-line). Chacune de ces deux familles a ses forces et faiblesses propres. Les CD-ROMs, grâce au débit d’information qu’il peuvent délivrer, permettent d’obtenir une grande richesse de la forme (séquences vidéos, effets graphiques riches, son de haute fidélité…) et des temps d’accès quasi-instantanés. En revanche, la quantité totale d’information accessible est limitée par le support physique (environ 600 Moctets pour la génération actuelle de CD-ROM, entre deux et quatre fois plus pour les CD-ROM haute densité qui vont rapidement apparaître). Les services multimédia accessibles en réseau sont très fortement limités par le débit des connexions et des temps d’accès parfois assez longs. En revanche, la quantité totale d’information en ligne n’est a priori pas limitée par le support physique. La ligne de partage entre ces deux familles est donc claire : CD-ROM pour des applications privilégiant l’interactivité sur la quantité d’information et Internet pour les applications exigeant de grands volumes d’information et pour lesquelles l’interactivité peut être plus limitée.

Enseigner avec le multimédia

Il y a une dizaine d’années l’Enseignement Assisté par Ordinateur (EAO) apparaissait à beaucoup comme un moyen de développer de nouvelles méthodes pédagogiques, plus efficaces que les méthodes pédagogiques traditionnelles. Certains brandissaient même le spectre d’un enseignement sans enseignants, l’ordinateur remplaçant les professeurs comme les métiers à tisser de Jacquard avaient remplacé les canuts lyonnais. Quelques années plus tard l’EAO a pris une place -modeste- dans notre dispositif pédagogique ramenant espoirs et craintes à une juste mesure.

Aujourd’hui, le multimédia se présente comme un nouvel outil. Selon certains, il va modifier en profondeur notre manière d’enseigner. Selon d’autres, le multimédia ne fera que rajouter quelques paillettes à des contenus traditionnels, changeant peut-être la forme des supports pédagogiques mais ne modifiant en rien les méthodes de travail des enseignants et des élèves. Dans un premier temps, il convient donc de se demander ce qu’apportent les technologies du multimédia par rapport aux supports traditionnels (tableau blanc, polycopiés, transparents, livres…). Dans un second temps, on peut tenter d’imaginer des usages possibles du multimédia et les nouvelles formes pédagogiques qui pourraient en être issues.

Une première caractéristique forte des technologies multimédia, tant sur CD-ROM que sur Internet, est qu’elles permettent des apprentissages en temps et en lieu différés. En cela, elles se rapprochent du polycopié par exemple. En outre elle permettent, en particulier via Internet, le développement de l’enseignement à distance, et du travail coopératif. Plusieurs étudiants, éventuellement dispersés géographiquement, peuvent coopérer sur un travail qui leur est proposé. Déjà des universités sans murs se sont ouvertes, l’ensemble des cours étant dispensé, sous forme de modules multimédia, via Internet6. Le Centre National d’Enseignement à Distance (CNED) lance son projet Campus Electronique. Ces formes d’enseignement rencontrent les difficulté classiques des enseignements à distance. Le manque de contacts personnels, enseignant-élèves ou élèves-élèves, ne permet pas certaines formes d’apprentissage (esprit d’équipe, convivialité…). Les moyens de communications associés à ces enseignements multimédia (courrier électronique, vidéoconférence…) tentent de limiter ce problème.

Une seconde caractéristique forte de ces technologies est la richesse des contenus et la luxuriance de la forme. Dans le domaine de l’enseignement, les « paillettes » du multimédia ont tendance, dans un premier temps, à rendre plus attractifs -les élèves diraient plus motivants- les supports de cours. On peut d’ailleurs remarquer que, culture audiovisuelle aidant, le niveau d’exigence des étudiants en matière de qualité de la forme ne cesse d’augmenter. Les polycopiés manuscrits du passé ont laissé la place aux polycopiés impeccablement mis en page grâce aux traitements de textes, les feutres à transparents ont laissé la place aux outils de Présentation Assistée par Ordinateur (PAO). Des animations 3D générées par ordinateur remplacent les croquis du professeur au tableau. Cette évolution n’est pas sans risques. Du côté de l’élève, en plus de la tentation du « zapping », évoquée plus haut, la prééminence de la forme sur le fond peut masquer l’essentiel et rendre plus obscur un contenu. Du côté du professeur, le temps passé à peaufiner la forme -la PAO est souvent chronophage- risque de dépasser celui consacré à l’élaboration du contenu pédagogique.

Une troisième caractéristique est l’interactivité que permettent les outils multimédia. Peuvent donc être proposés à l’étudiant des cheminements multiples, des exercices, des simulations, des laboratoires virtuels lui permettant d’effectuer des expériences et de mettre en oeuvre des connaissances. Les perspectives ouvertes, pour l’enseignement, par les capacités d’interactivité et de simulation sont extraordinaires. Le multimédia permet alors, sur un seul support, de faire alterner théorie et pratique, d’adapter la méthode pédagogique à l’étudiant, de proposer l’illustration (son, graphique, vidéo, texte,…) la plus adaptée au concept ou au savoir-faire étudié. Là encore, si le multimédia a des apports indéniables, il convient d’en mesurer les limites. L’enseignant qui conçoit un support multimédia d’apprentissage autonome est partagé entre deux stratégies : la promenade ou le parcours guidé. S’il choisit de privilégier la promenade, il laissera l’étudiant choisir librement l’ordre dans lequel il aborde les choses. L’interactivité et la liberté de choix de l’étudiant est maximale. L’enseignant fait implicitement l’hypothèse que l’étudiant est meilleur prescripteur de la méthode pédagogique qui lui est appropriée. L’expérience montre que ce principe peut être remis en question. Si l’enseignant limite l’interactivité et prépare un nombre limité de cheminements, de parcours, il risque de « mettre en boîte » une pédagogie qui ne sera pas adaptée à un étudiant donné. Dans les deux cas, nous sommes limités par le faible niveau d’intelligence qu’il est possible d’intégrer dans un produit multimédia. Des produits plus intelligents pourraient adapter la pédagogie proposée à chaque élève, ce que fait quasi-instinctivement un enseignant en chair et en os. Dans ce domaine, il est extrêmement important de mener des expériences. Les réflexions menées lors de l’une d’entre elles sont décrites dans le chapitre suivant.

Il est un dernier point qu’il est difficile d’éluder lorsque l’on parle de multimédia et de pédagogie. C’est celui des coûts, point crucial dans un contexte budgétaire difficile pour l’enseignement supérieur. Produire un support de cours multimédia de qualité est aujourd’hui coûteux. Un module d’enseignement « mis en multimédia » sur Internet revient entre deux et quatre fois plus cher à développer qu’un polycopié classique. Le développement d’un CD-ROM coûte entre dix et vingt fois plus cher qu’un polycopié. Ces coûts élevés peuvent bien entendu être réduits en partageant les coûts entre plusieurs établissements, qui utiliseraient tous le même support. Internet se prête très bien à l’échange de matériaux pédagogiques, et l’on y trouve déjà nombre de cours prêts à l’emploi. Le problème reste posé du financement de l’équipement de tous les étudiants avec un ordinateur personnel leur permettant d’étudier, de manière confortable, des supports de cours multimédia.

Un exemple de réflexion pédagogique

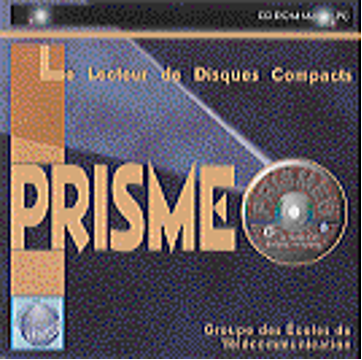

Le projet ERNEST a été initié par la Direction de l’Enseignement Supérieur des Télécommunications, dans le cadre de l’appel « autoroute de l’information ». Le développement d’un CD-ROM dont le sujet porte sur le « Lecteur de Disques Compacts » y est effectué par des enseignants et des étudiants. Ce développement a donné lieu à une réflexion approfondie sur la pédagogie à mettre en oeuvre dans ce type de support, réflexion menée conjointement par des enseignants de domaines techniques et de sciences humaines.

Le contenu du CD-ROM est découpé en articles, regroupés en sept domaines. Chaque article introduit, explique et met en application un concept ou une notion liée. Un glossaire technique expliquant et traduisant les principaux termes et sigles utilisés, ainsi que des références permettant à l’utilisateur d’en savoir plus, complètent l’article. Des liens pédagogiques (corrélats) sont aussi proposés vers d’autres articles liés pour apporter un éclairage complémentaire d’un autre domaine ou du même domaine (voir hors-texte).

Notre réflexion repose sur trois principes essentiels visant à faciliter l’acquisition autonome, claire et différenciée des connaissances proposées :

1 – Contenu fortement structuré :

Le déplacement dans le contenu repose sur le suivi de « parcours d’articles ». Il est possible de suivre des parcours prédéfinis lorsque l’on est débutant puis de créer ses propres parcours. Au sein des parcours, la continuité de lecture est privilégiée. De façon à rendre plus complète l’immersion pédagogique dans le contenu du disque compact, il a été choisi de proposer à l’utilisateur un déplacement de contenu en contenu sans avoir à repasser en permanence par des « écrans de navigation». Cette dernière solution reste toutefois une possibilité permanente, qui suppose une action volontaire de l’utilisateur, sans être imposée.

Le contenu du CD-ROM est structuré selon plusieurs approches, l’une d’entre elles est imposée, les autres sont disponibles en fonction du niveau et des besoins de l’utilisateur pour une structuration progressive de sa pensée.

• une approche guidée propose à l’utilisateur débutant des parcours pédagogiques prédéfinis mono et multi-domaines.

• l’utilisateur plus expérimenté peut ensuite créer lui même ses propres parcours à partir des parcours précédemment suivis,

• enfin, il peut établir des parcours complètement personnels.

2 – Des formes graduelles d’interactivité

Une gamme d’exercices fondés sur des formes graduelles d’interactivité est proposée. Trois types et niveaux d’exercices ont été identifiés, notre projet tentera de les implémenter tous les trois.

- Niveau 1 : illustration active. Ce niveau correspond à une appropriation d’un concept par l’utilisateur. Dans le domaine des sciences cognitives ce niveau pourrait correspondre à l’acquisition du vocabulaire. Cette illustration active peut prendre par exemple l’aspect d’une visualisation graphique avec des paramètres modifiables.

- Niveau 2 : laboratoire virtuel d’expérimentation. Ce niveau correspond à une appropriation d’un savoir faire, assemblage ou modification de concepts déjà connus et identifiés par l’utilisateur. Dans le domaine des sciences cognitives, ce niveau pourrait correspondre à l’acquisition du savoir faire.

- Niveau 3 : laboratoire virtuel de conception. Ce niveau correspond à la fabrication d’un concept par l’utilisateur. Dans le domaine des sciences cognitives ce niveau pourrait correspondre à la reproduction du savoir faire (phase de création).

3 – L’utilisateur doit pouvoir se situer

L’utilisateur peut comprendre en permanence la structure du document et repérer sa situation d’apprentissage. Il nous semble essentiel que l’utilisateur ait en permanence une appréhension aussi juste que possible de son environnement, contrairement à ce qui se passe pour d’autres types de produit CD ROM, qui proposent des démarches en « aveugle ». Cela signifie qu’il faut que l’utilisateur sache rapidement se situer par rapport à des points de repère, qu’il sache si tel ou tel type d’information est localement disponible ou pas, et qu’il sache ce qu’il l’attend s’il effectue tel ou tel type d’action. Ce choix a de très nombreuses conséquences en ce qui concerne la localisation « spatio-temporelle » des informations, l’utilisation des codes métaphoriques, la structure des écrans et des boutons et surtout les déplacements possibles dans le contenu.

Plusieurs outils sont mis à la disposition de l’utilisateur pour qu’il soit en mesure de suivre son évolution tout au long de son travail sur le CD. Ces outils sont basés sur la mémorisation multi-sessions des actions et choix de l’utilisateur (dossier de suivi) : cela permet à ce dernier de visualiser à tout moment ce qu’il a déjà étudié ou ce qui lui reste à étudier. Il lui est aussi possible de marquer un article sur lequel il souhaite revenir plus tard ou même d’annoter cet article s’il lui vient une question, une idée, etc. Plus tard il pourra facilement les visualiser pour y revenir rapidement ou retravailler sur les notes prises.

Arnaud Galisson, responsable du projet, ENST

Enseigner le multimédia

Le multimédia s’appuie sur un ensemble de technologies sur lesquelles de nombreux scientifiques et ingénieurs ont travaillé, depuis parfois près de cent ans (le mot télécommunication a été proposé par E. Estaunié en 1904). Aujourd’hui, des disciplines traditionnellement enseignées dans certaines écoles d’ingénieur (informatique, électronique, télécommunications, traitement du signal) sont à la base des technologies du multimédia. Les besoins de l’industrie du multimédia dans ces disciplines sont donc couverts, éventuellement au prix d’adaptations marginales des cursus, liées aux spécificités du multimédia. Dans ce domaine en évolution rapide, le monde de l’entreprise doit veiller à formuler clairement ses besoins et le monde académique doit être vigilant et s’adapter, tout en évitant bien entendu les effets de mode.

Une question plus épineuse porte sur les nouveaux savoir-faire et métiers qui seraient propres aux contenus multimédia. Ces nouveaux savoir-faire portent sur deux dimensions : il s’agit d’apprendre à « lire » et à « écrire » le multimédia.

Le multimédia semble facile d’accès dans un premier temps et l’on peut légitimement se demander s’il est nécessaire d’apprendre à lire le multimédia. Les utilisateurs, confrontés en permanence à un environnement très fortement audiovisuel, ont l’habitude de décoder et comprendre des contenus composites (sons, textes, images…). L’ergonomie de l’accès aux documents multimédia, toujours plus intuitive, en facilite l’usage. Néanmoins, la richesse même des documents multimédia, l’immense volume de données et de contenus accessibles par quelques « clics » de souris, la souplesse et la puissance des méthodes d’accès sont la source de difficultés : tentation permanente du « zapping », difficulté à se situer et difficulté à transformer une information vue en un apprentissage réel.

La première de ces difficultés est évidente. La télévision, aux capacités d’interactivité pourtant limitées au seul choix du canal, engendre chez beaucoup un « zapping » effréné, dont au moins une des causes est l’insatiable curiosité de l’esprit humain. Dans un CD-ROM ou sur Internet, la tentation est grande d’aller voir ce qu’il y a derrière chaque bouton, derrière chaque lien hypertexte et le phénomène est amplifié. L’esprit occupé à découvrir se mobilise peu pour comprendre et apprendre.

La seconde est liée à la masse d’information et à la richesse de la structuration de cette information. En simplifiant, le livre, le film sont linéaires, le contenu d’un serveur Minitel est essentiellement un arbre dans lequel il est simple de se repérer. Les supports multimédia rendent possible des structures quelconques, sortes de réseaux sémantiques multiformes. Certaines de ces structures sont statiques : elles sont figées lors de la conception et l’utilisateur « passant » à un même « endroit » trouvera les mêmes « chemins ». Certaines peuvent être dynamiques, les « chemins » offerts dépendant du contexte, de l’histoire de la consultation, de requêtes spécifiques émises par l’utilisateur. Les risques de se perdre sont réels.

La troisième difficulté est plus subtile. La page traditionnelle, le livre, ont de toute évidence contribué à structurer nos esprits : culture, méthodes d’apprentissages et représentation des choses (concepts, connaissances,…). Il n’est pas évident que les nouvelles formes de représentation proposées par le multimédia soient immédiatement assimilables. Il a fallu une génération pour que l’écriture cinématographique, lorsqu’elle s’écarte de la narration linéaire, devienne évidente pour tous. Il faudra probablement une génération pour que l’écriture multimédia ait été « intégrée » de la même manière. Dans l’intervalle, il est probable que lire et assimiler réellement le contenu d’une information multimédia ne soit pas aussi aisé que cela. Ce phénomène est amplifié par les deux difficultés précédemment mentionnées.

On le voit, lire le multimédia n’est peut-être pas si facile. Les enseignants, du primaire à l’enseignement supérieur, peuvent contribuer à développer les savoir-faire dans ce domaine.

Si lire le multimédia n’est pas évident, l’écrire l’est encore moins. L’art de l’écriture multimédia en est à son balbutiement. A n’en pas douter beaucoup d’expériences vont être menées, tant sur les aspects formels que sur les manières de structurer et de présenter un contenu. Différents styles d’écritures -probablement en grand nombre- vont peu à peu émerger et se cristalliser. Des métiers nouveaux sont en train d’apparaître et leur contours se précisent peu à peu. Il y a des « concepteurs » de contenus aux compétences proches de celles de scénaristes et des concepteurs de systèmes d’information. Il y a des « ergonomes » qui conçoivent les interfaces de navigations. Il y a des photographes, des graphistes, des ingénieurs du son, des cinéastes, qui produisent des éléments de contenus. Il y a enfin les développeurs aux compétences proches de l’informatique, qui vont assembler tout ces éléments et créer les documents multimédia finaux. Si chacun de ces métier reprend des compétences qui ne sont pas nouvelles, tous sont cependant nouveaux et sont en train de forger les méthodes et outils qui leur sont nécessaires. Ils ont la particularité de mêler fortement des dimensions techniques (maîtrise des technologies du multimédia) et des dimensions artistiques et littéraires.

Les besoins de l’industrie des services et de contenus sont déjà importants et croissent très rapidement. Les enjeux de formation sont très sérieux : combien d’étudiants faut-il former à ces nouveaux métiers, quels contenus de formation faut-il mettre en place, quelles écoles sont le mieux à même de proposer ces nouvelles formations? Dans ce domaine, de nombreuses expériences seraient à signaler. L’Ecole Nationale Supérieure des Télécommunications participe à deux d’entre elles. En association avec l’Ecole Polytechnique Fédérale de Lausanne, elle a crée à Sophia Antipolis EURECOM, qui délivre dans l’une de ses options des diplômes d’ingénieur spécialisé dans les technologies du multimédia. En association avec les Beaux Arts, elle participe à un programme de mastère Multimédia-Hypermédia[2]le Mastère Multimédia-Hypermédia commun entre l’ENST et l’école des beaux-arts a été créé en 1995, qui permet, au cours d’un cursus d’un an, de former des étudiants graphistes aux techniques spécifiques du multimédia, comprenant les technologies sous-jacentes et capable de dialoguer avec des techniciens. Dans le même esprit, le groupe ESIEE associé avec INA-Formation (Institut National de l’Audiovisuel) propose aussi un Mastère « Ingénierie du Multimédia ».

Conclusion

Les éléments de réflexion qui précèdent tentent de montrer que, comme pour le multimédia comme pour toute technologie nouvelle, il faudra du temps pour en appréhender pleinement les bénéfices pour la pédagogie. Des limites sont déjà soupçonnées ; un potentiel énorme est entrevu. Les pratiques pédagogiques classiques doivent être revues à l’aune du multimédia, et de nouvelles formes d’enseignement doivent être élaborées. Les enseignants doivent acquérir la maîtrise de nouveaux outils. Grandes écoles et universités se sont attelées à cette tâche avec enthousiasme. Il est maintenant urgent d’expérimenter ces supports en grandeur réelle, et d’analyser leur impact sur les élèves.

Sources Documentaires on-line

La presse l’a affirmé : Internet et les autoroutes de l’information feront la révolution industrielle de l’an 2000. Déjà, la machine tourne à plein régime. Les états, dans la sphère occidentale tout au moins, ont décidé la construction d’autoroutes de l’information. Les opérateurs de télécommunication se préoccupent de prélever leur dîme. Les entreprises se précipitent pour créer services et serveurs, et les particuliers concoctent et mettent en réseau leurs pages personnelles. Entre cinquante et cent millions de personnes de par le monde sont « connectées ». Internet a soufflé la bougie fêtant le franchissement du cap du milliard de pages d’informations hypertexte disponibles en réseau.

Déjà, les aspects socioculturels du cyber-espace sont débattus, la cyber-économie est étudiée[3]Le Monde Diplomatique, Février 1995, Mai 1996. Déjà, des peurs naissent ici et là autour du spectre de l’homme virtuel et de l’émergence du cerveau planétaire[4]L’homme symbiotique, Joël de Rosnay, 1995.

Internet connaît donc une croissance extraordinaire. Si les média ont surtout mis en avant les aspects ludiques d’Internet, bon nombre de professionnels l’utilisent maintenant quotidiennement. Internet, et en particulier le World Wide Web, est en passe de devenir la source documentaire la plus vaste qui soit. Les chercheurs y trouvent des articles scientifiques, les enseignants des cours préparés par d’autres, les ingénieurs peuvent consulter des catalogues de composants électroniques et les commander. Plus d’un milliard de pages sont aujourd’hui accessibles, et cette mine d’information croit exponentiellement.

Comparé aux sources documentaires classiques (CD-ROM thématiques proposés par des éditeurs ou des consultants), Internet possède de nombreux avantages : il est mis à jour en permanence, il est gigantesque et offre une interface simple et intuitive. Cependant, chacun de ces avantage soulève une question clef : comment contrôler la qualité de l’information, comment trouver ce que l’on cherche et comment en favoriser le développement?

Internet s’est construit avec une philosophie particulière : sorte d’autogestion à l’échelle planétaire, où chacun pose quelques briques qu’il relie au reste de l’édifice. Aucun « grand architecte » n’a pensé ce gigantesque système d’information, aucun « grand mainteneur » ne veille à sa cohérence et à sa stabilité. De nombreux problèmes en résultent : informations de pertinence inégale, informations obsolètes jamais remises à jour, doublons, informations parcellaires sur un sujet disséminées à travers le monde, zones d’ombres. Internet s’est vite transformé en un attachant, et parfois énervant, fourre-tout planétaire. La question de la qualité de l’information disponible est aujourd’hui mal résolue.

Fort heureusement, des outils de recherche de plus en plus puissants sont apparus. Des millions de pages sont indexées chaque jour et un utilisateur peut lancer des moteurs de recherche à l’aide de mots clefs. Souvent, le résultat de la recherche est une riche moisson et l’utilisateur doit se donner la peine de séparer le bon grain de l’ivraie, pour enfin accéder à l’information qu’il souhaite. Beaucoup de travail reste à fournir pour améliorer encore ces outils et en faire de véritables agents intelligents, capables de retrouver une information pertinente dans ce fourre-tout planétaire, de la digérer et de la synthétiser. Il s’agit d’un des défis majeurs des prochaines années pour la recherche.

Le développement d’Internet est lié à l’activité d’entreprises ou d’individus qui mettent en forme des informations pour les mettre à disposition d’autres. Les entreprises espèrent bénéficier de leur effort dans ce domaine sous la forme de publicité, d’image, ou de bénéfices accrus. Les motivations des personnes privées sont, elles, généralement non commerciales et le plus souvent altruistes. Il s’agit de faire bénéficier le plus grand nombre de ce que l’on sait ou de ce que l’on aime. Ces motivations, courantes aux débuts de la croissance d’Internet, risquent de montrer rapidement leurs limites. Le petit groupe de « branchés » partageant une certaine éthique est devenu, à la suite de l’explosion récente du nombre d’utilisateurs, une micro-société à part entière. On y trouve tous les éléments qui caractérisent une société complexe : l’altruisme comme la recherche du profit, l’honnêteté comme la malhonnêteté, la beauté comme la laideur, l’intelligence comme l’obscurantisme… L’altruisme risque de disparaître au profit des seuls intérêts commerciaux. L’équilibre entre ceux qui, au prix d’un effort, donnent de l’information, et ceux qui l’utilisent risque d’être rompu par des consommateurs sans scrupule, prenant sans jamais donner. L’écosystème Internet risque d’être submergé par des « détritus informationnels » que personne ne se donnera la peine de retirer du réseau. On l’a vu, l’utilité future d’Internet comme serveur d’informations repose en grande partie sur la qualité de l’information que l’on peut y trouver. Seul l’équilibre et la croissance harmonieuse de la micro-société Internet permettra de développer cette qualité. Imaginer et imposer les règles de fonctionnement (une constitution?) permettant cette croissance harmonieuse constitue un enjeu important.

Accroître la qualité de l’information disponible, développer des agents intelligents pour y accéder, et reconnaître que sa complexité rend nécessaire l’équivalent d’une constitution pour réguler son fonctionnement : c’est à ce prix qu’Internet pourra devenir un serveur documentaire universel.